FERTIG INSTALLIERT MIT READY-TO-BRAIN™ TECHNOLOGIE

Eine Maschine für Deep Learning Anwendungen zu installieren und einzurichten dauert mitunter mehrere Tage, und gleicht eher einem Trial-and-Error Verlauf. Verwenden Sie Ihre Zeit lieber sinnvoll für Erstellung und Training von neuronalen Netzen, anstatt mit zeitraubenden Linux Installations- und Konfigurationsschritten. Durch die Ready-to-Brain™ Technologie von CADnetwork® sind unsere Geräte sofort einsatzbereit. Die Server werden komplett fertig mit den gängigsten AI Tools geliefert, so sparen Sie sich Zeitaufwand und können direkt mit Ihren eigentlichen Aufgaben beginnen.

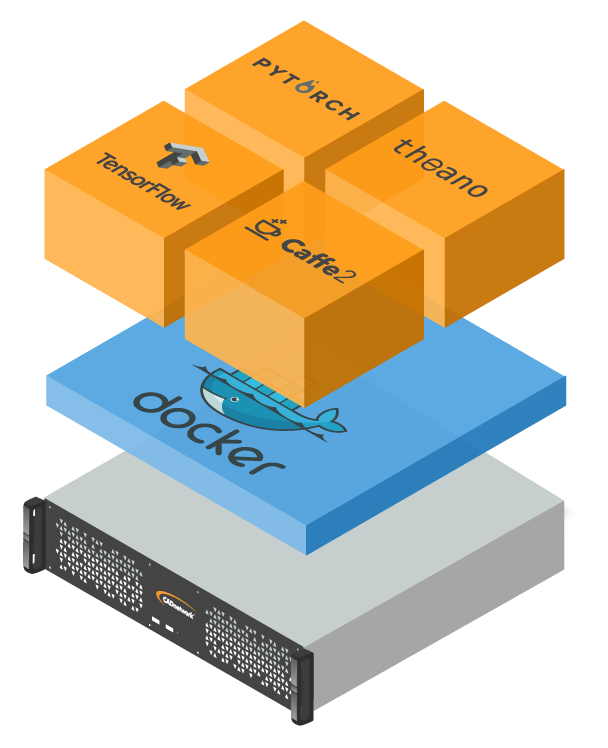

KOMPATIBEL MIT VIELEN KI FRAMEWORKS

Die Geräte der Deep Learning Box Familie sind kompatibel mit allen gängigen KI Frameworks kompatibel. Es können die bereits fertig installierten Frameworks wie TensorFlow, PyTorch oder Caffe2 genutzt werden, oder eigene installiert und verwendet werden. Durch die bereits installierte docker Umgebung können ganz einfach Deep Learning Frameworks in docker container heruntergeladen und genutzt werden.

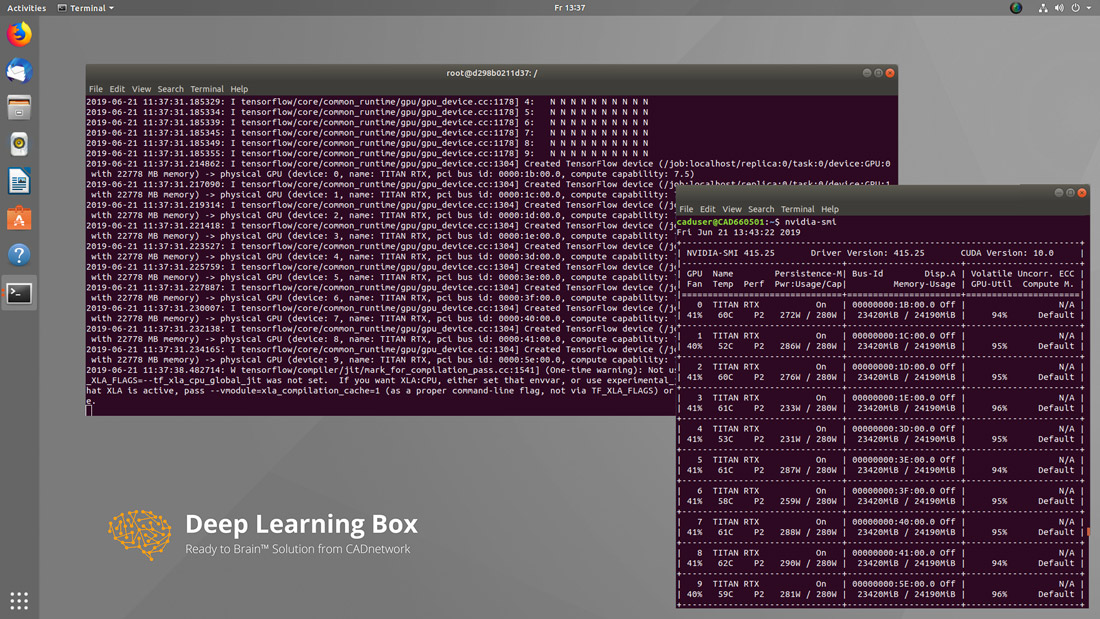

MIT UMFANGREICHEM DL SOFTWARESTACK

Die CADnetwork® Deep Learning Box ist mit einem umfangreichen Softwarestack für AI Anwendungen ausgestattet. Die Deep Learning Frameworks und Bibliotheken sind hierbei in komfortablen docker Containern angeordnet und ermöglichen so einfachen und stabilen Zugriff auf die Ressourcen. Die gängigsten Frameworks wie z.B. TensorFlow, PyTorch, Caffe2 und Keras sind bereits fertig installiert und sofort einsatzbereit